提示:要先安装CUDA,再装Ollama,避免大模型跑在CPU上

1、安装CUDA(不然就只会用CPU运行模型)

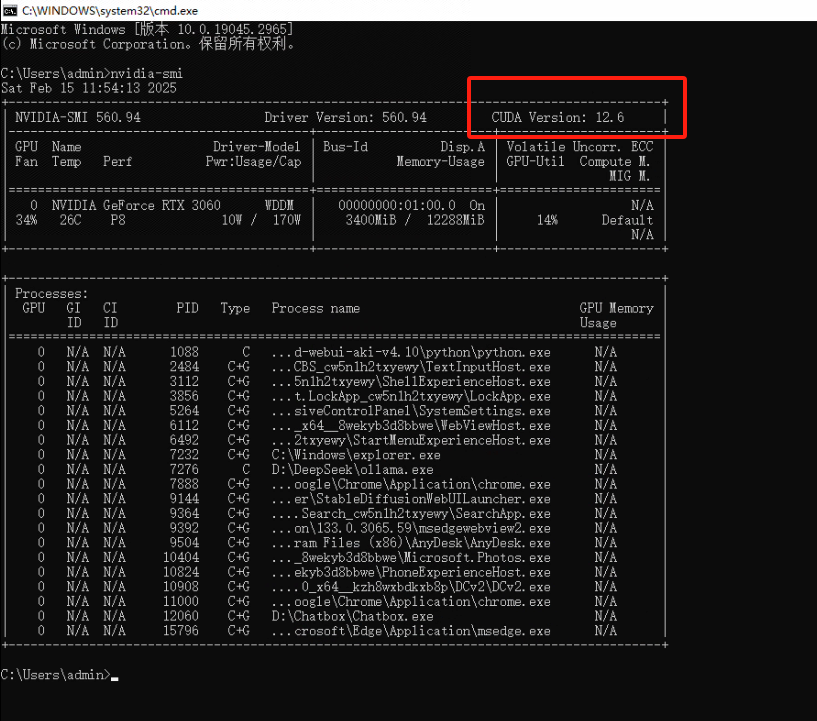

(1)在cmd窗口运行nvidia-smi,查看CUDA的版本

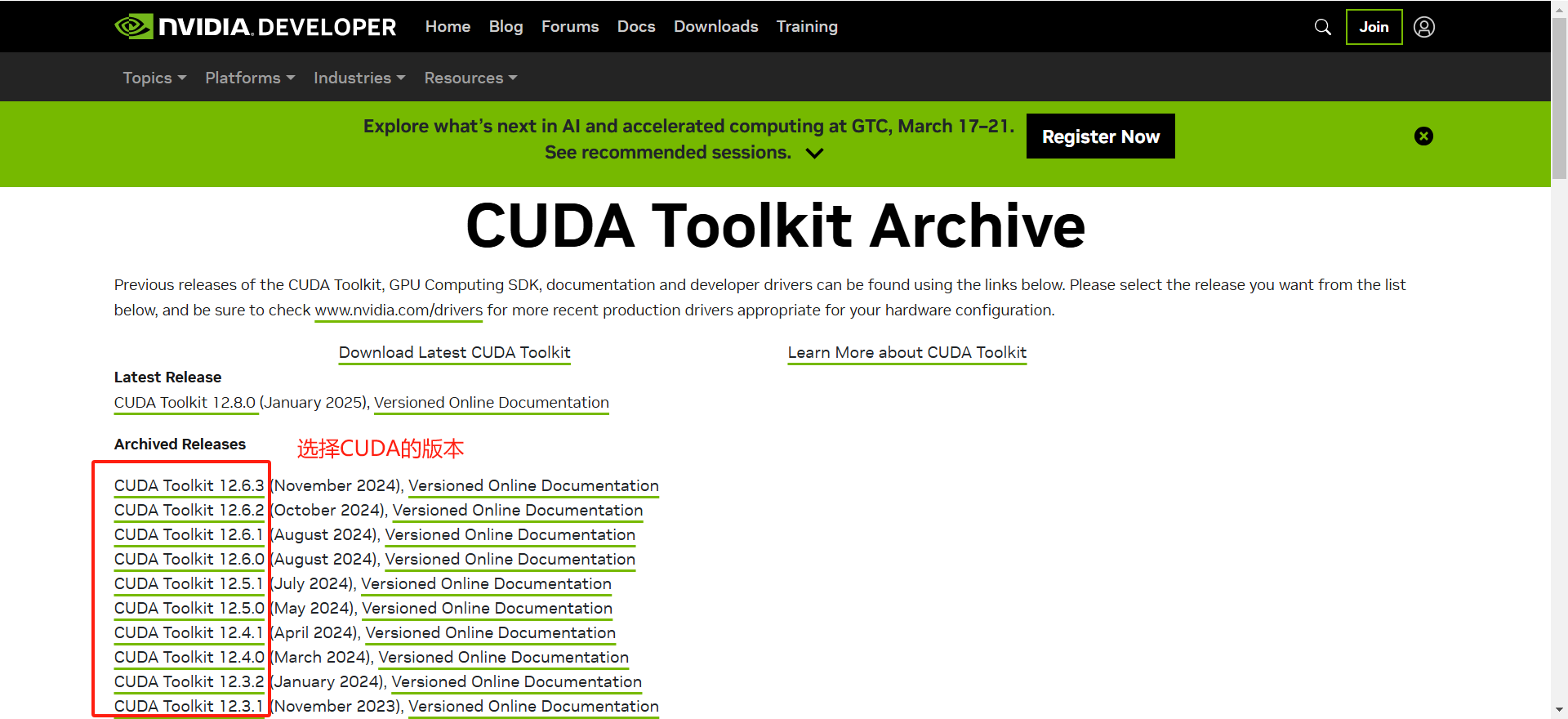

(2)下载CUDA程序(英文界面有点绕)

(3)安装CUDA(一般是默认安装就行,需要自定义自行选择)

2、到Ollama官网根据你的平台下载并安装最新的Ollama软件(也可以选择用网站提供下载的程序)

默认安装是装到C盘的,需要装到其他盘,就看完这个操作,不需要可以直接跳到第3步:

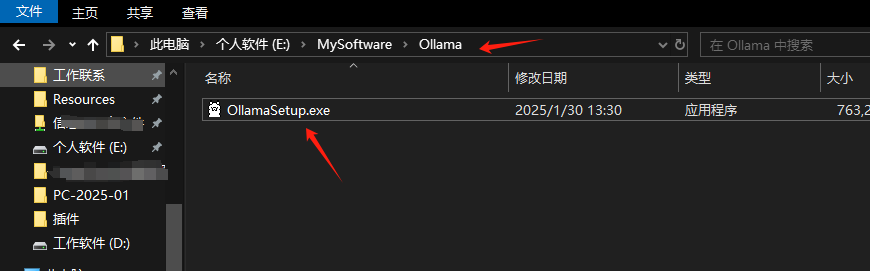

(1)首先在你想安装的路径下创建好一个新文件夹,并把Ollama的安装包放在里面。比如我的是: E:\MySoftware\Ollama

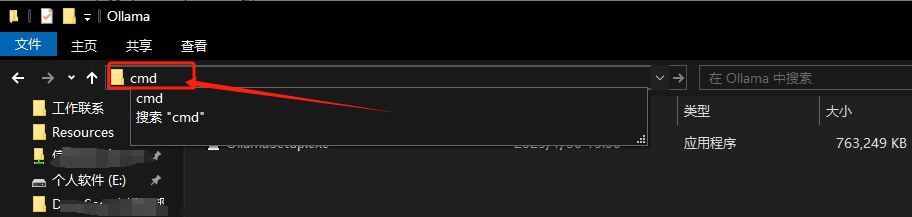

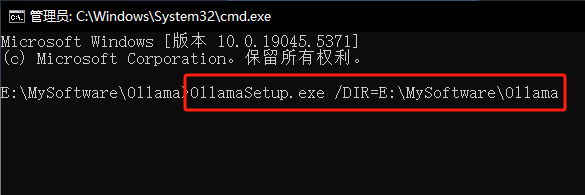

(2)在文件路径上输入CMD回车后会自动打开命令窗口

(3)在CMD窗口输入:OllamaSetup.exe /DIR=E:\MySoftware\Ollama

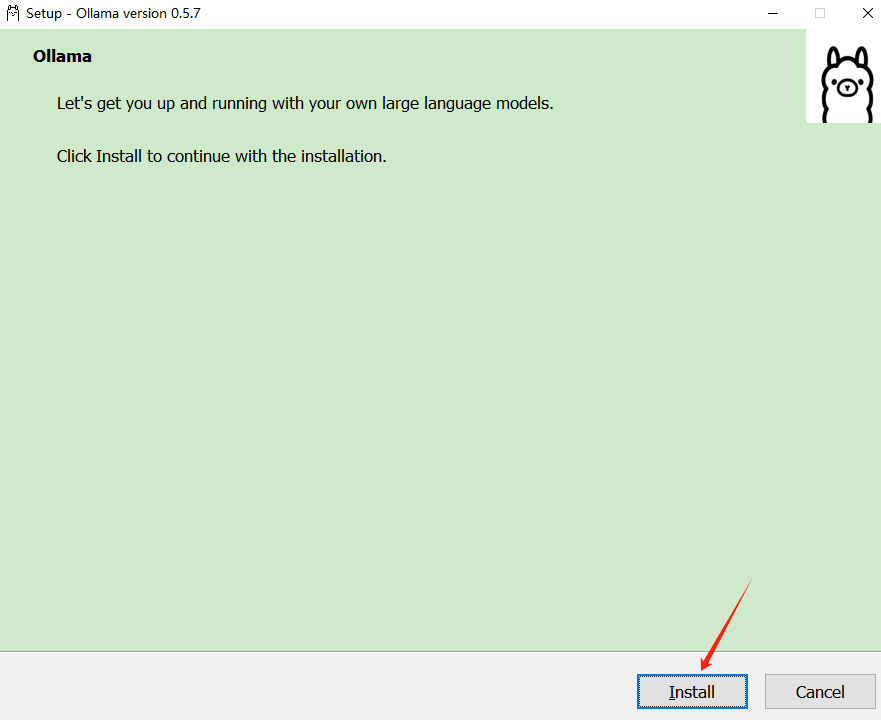

(4)回车之后,会弹出Ollama的安装窗口,继续完成安装就行

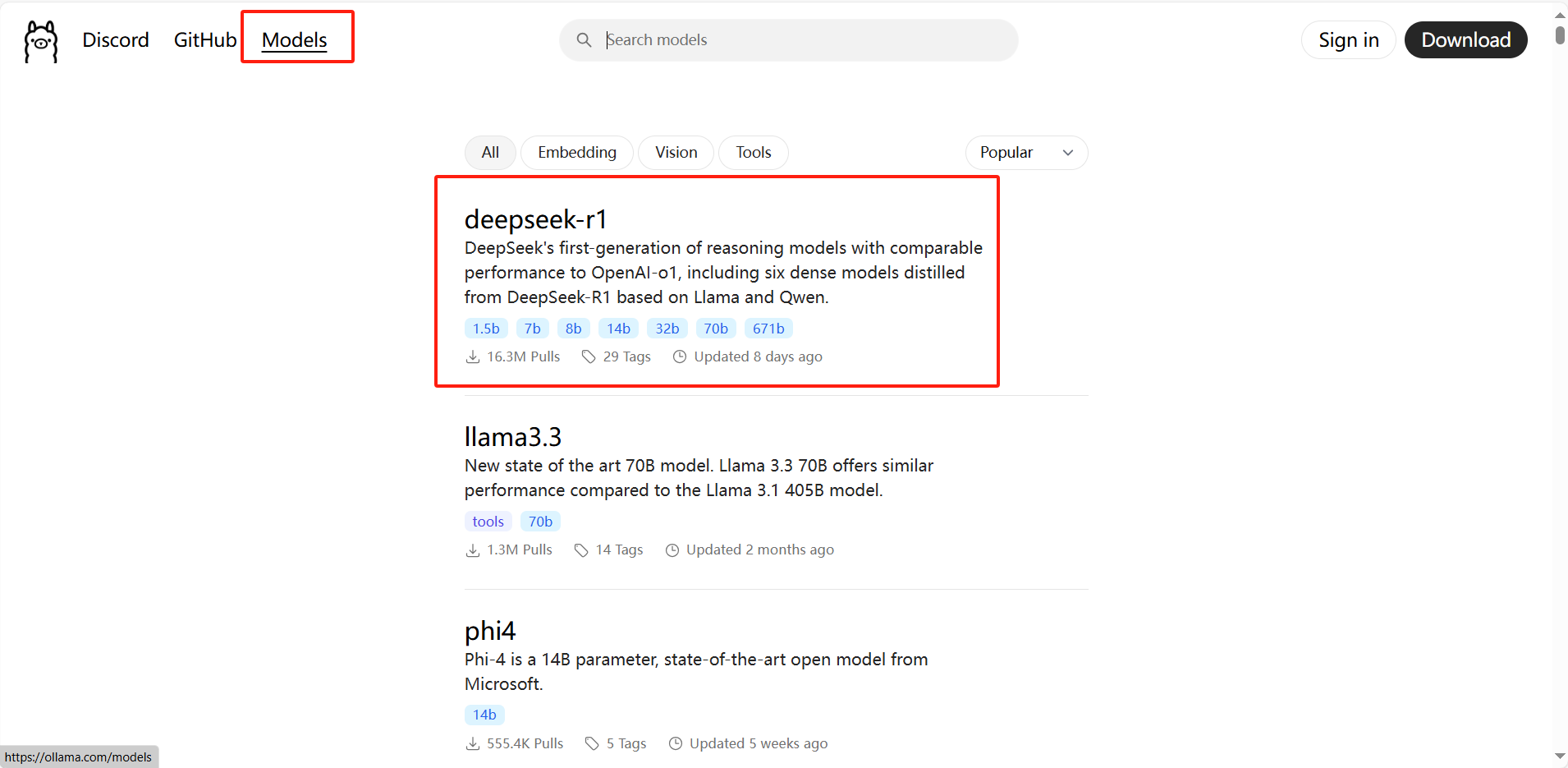

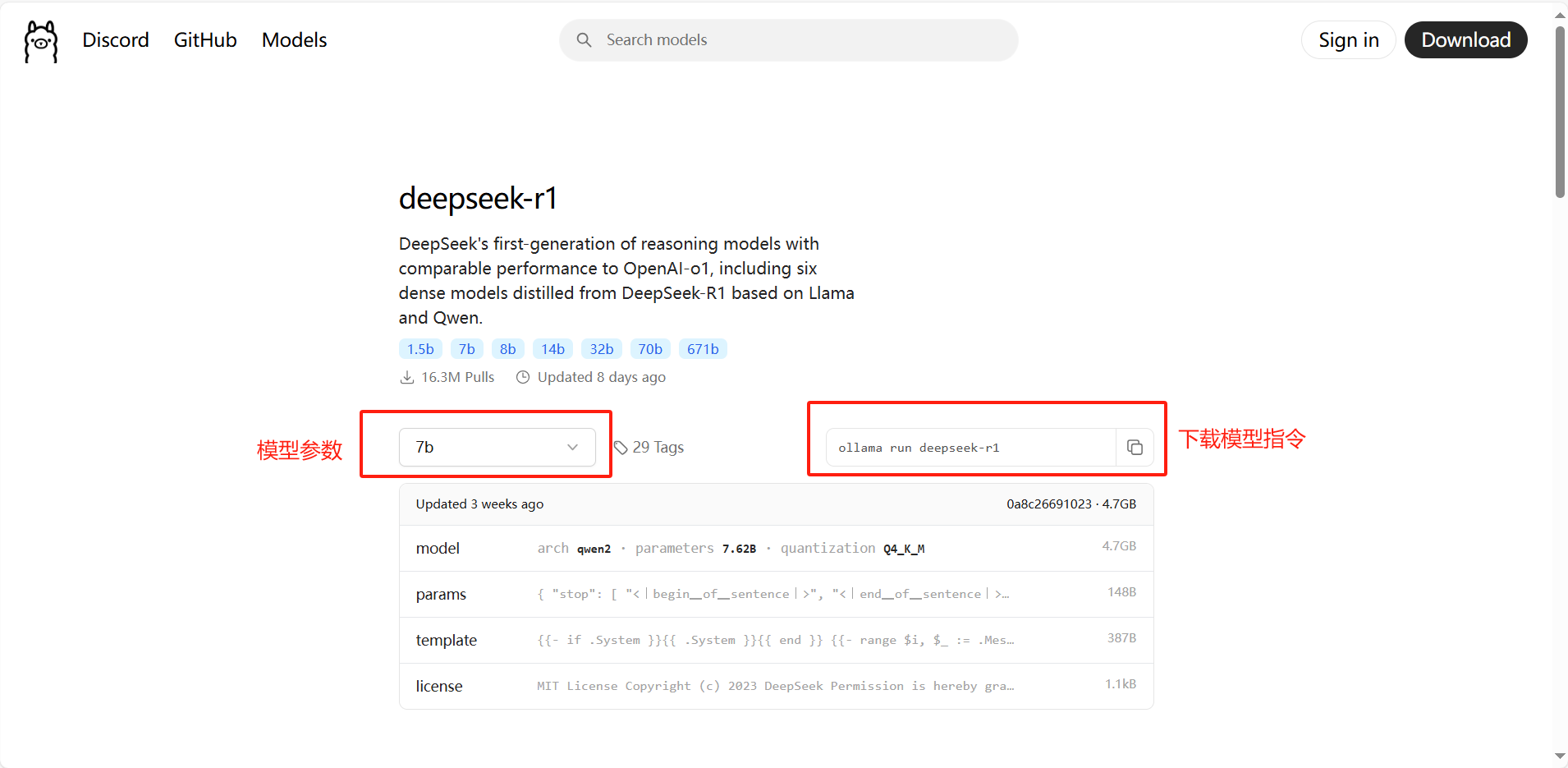

3、下载deepseek-r1模型(根据自己显卡的配置选择,我的显卡是3060的,选泽14b的下载)

提示:看清楚下图提示呦!

4、在CMD窗口运行下载模型的指令:ollama run deepseek-r1:14b

直接运行是下载到C盘的,需要修改模型下载的位置,请继续往下看,不需要可以直接跳到第5步:

接下来这几步是增加环境变量的操作:

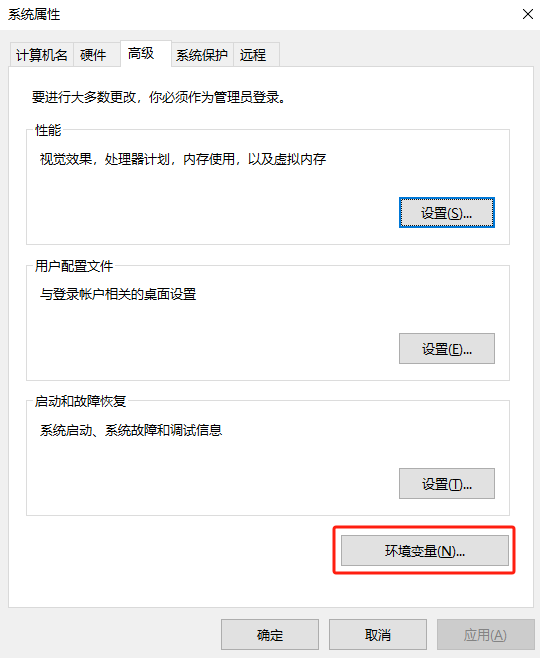

(1)新增好存储模型的文件夹后,鼠标右键我的电脑–>属性–>高级系统设置–>环境变量

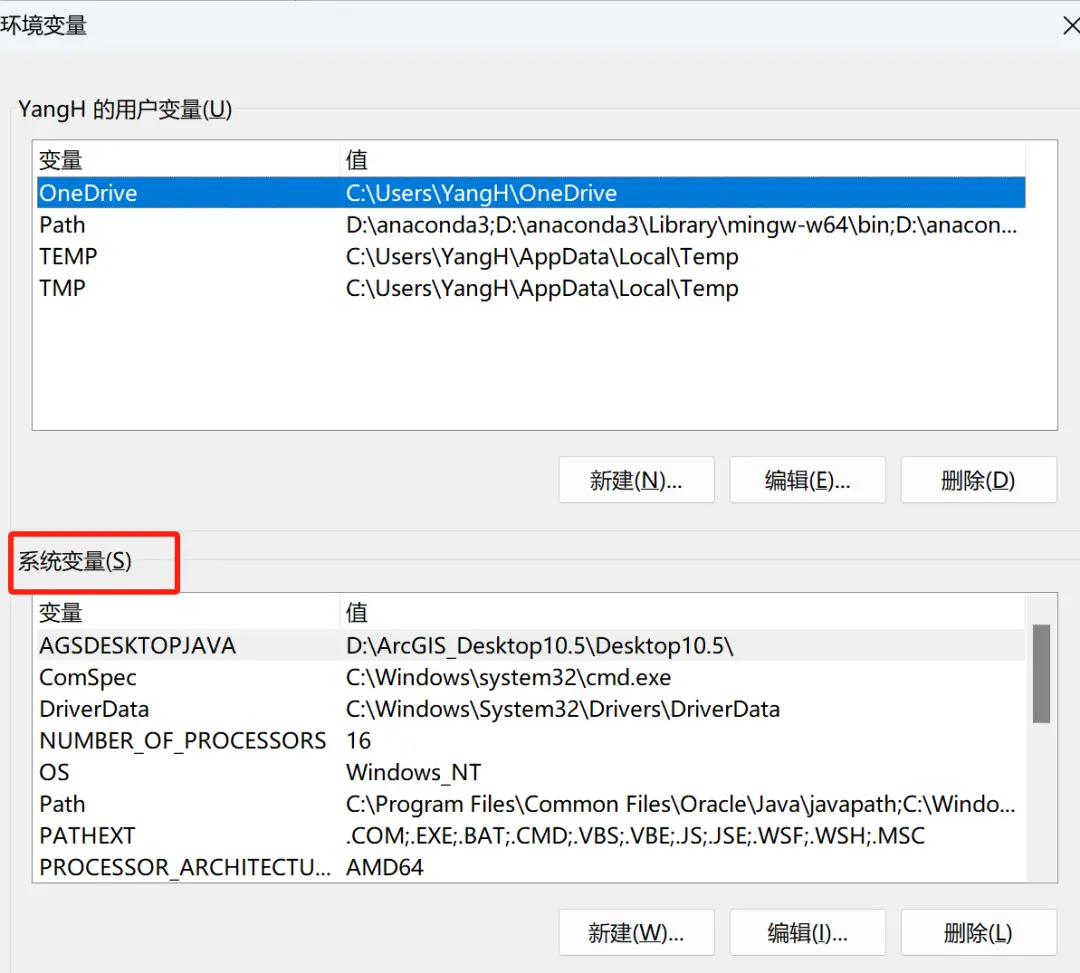

(2)在环境变量中找到“系统变量”(我看有些博主新增的用户变量,其实问题也不大的,但是建议还是用系统变量)

(3)在“系统变量”中点击“新建”按钮,并输入如下信息。

变量名:OLLAMA_MODELS

变量值:D:\OllamaModel

(4)重新在CMD窗口运行下载模型的指令:ollama run deepseek-r1:14b

5、启动ollama程序(在应用菜单里启动下,安装完没有将快捷方式释放到桌面)

运行大模型:在cmd窗口运行 ollama run deepseek-r1:14b,就可以玩耍了,需要愉快的玩耍,请继续往下看:

6、接下来就是装一个交互界面:Chatbox

问题记录

问:1、运行大模型的时候,为什么只跑CPU的资源?

答:有两个地方可以优先检查:

(1)用nvidia-smi命令检查下CUDA的版本是否一致

(2)是不是先装的Ollama再装的CUDA驱动,可以将Ollama卸载重装一次(其他不用重装)